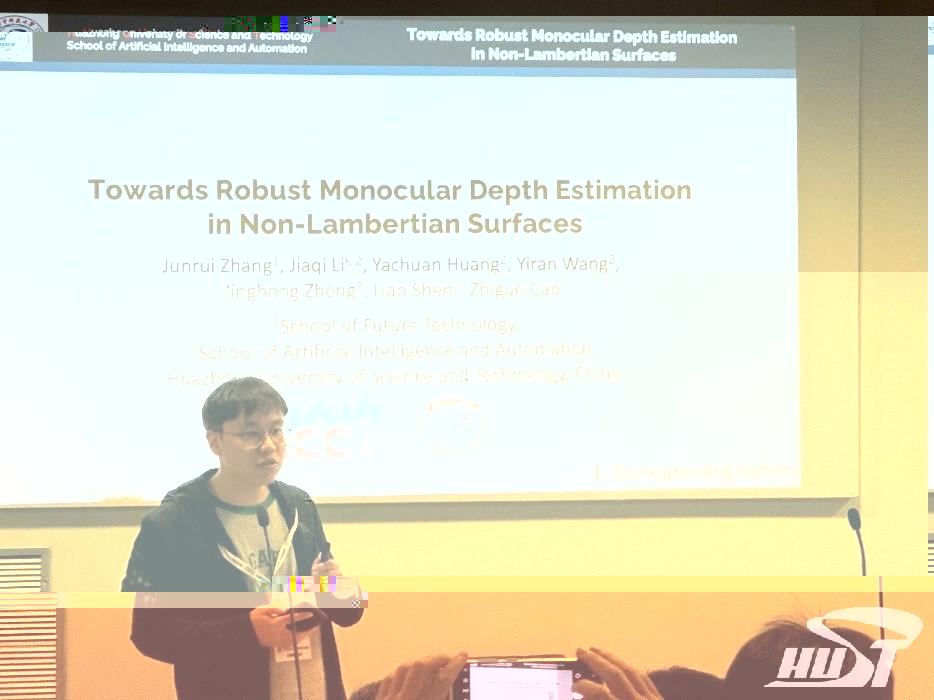

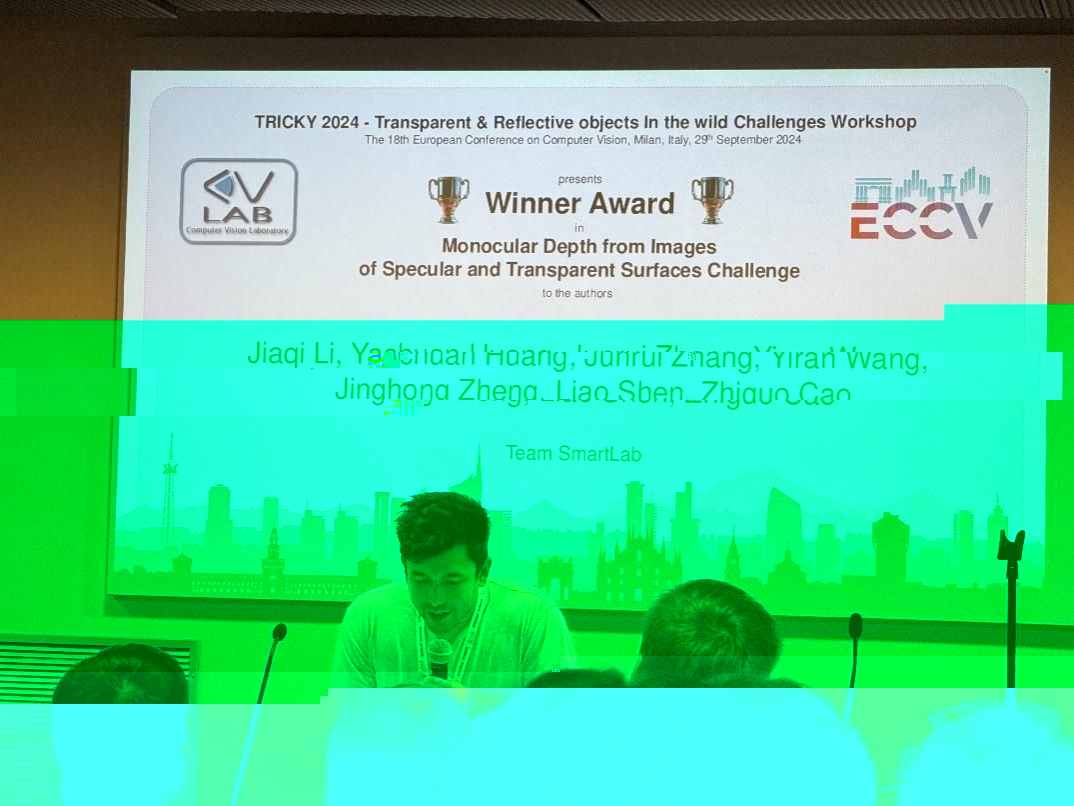

新聞網訊 9月29日,歐洲計算機視覺會議(ECCV2024)在意大利米蘭召開。大會組織的“TRICKY 2024:Transparent & Reflective objects In the wild Challenge (自然場景透明和反射物體挑戰賽)”的“Monocular Depth from Images of Specular and Transparent Surfaces Challenge (鏡面和透明表面圖像的單目深度估計)” 賽道比賽結果揭曉,我校88858cc永利2021級本科生張峻瑞參與的競賽團隊(Smartlab)獲得全球冠軍。張峻瑞以第一作者的身份撰寫了學術論文“Towards Robust Monocular Depth Estimation in Non-Lambertian Surfaces”介紹參賽項目,并受邀在大會Workshop上進行論文學術交流。

單目深度估計是近年來計算機視覺領域的研究熱點之一,它是自動駕駛、物體姿态估計、SLAM、虛拟現實、新視圖生成、計算攝影等衆多領域的基礎技術,有着廣泛的應用前景。雖然單目深度估計算法近年來已經取得了長足進步,但當場景中存在透明或鏡面反射物體時,現有的單目深度估計模型的性能均會急劇下降,究其原因在于當場景中存在玻璃或金屬等非朗伯體時,這些物體的表面通過反射或折射的方式,可以複制場景中其他處于不同深度物體(包含非朗伯體)的顔色、紋理等外觀信息,導緻不同深度結構的物體在深度語義上引起混亂,從而形成了難以預測的深度結構。而現有的深度預測模型往往建立在“朗伯世界”的假設下,即訓練數據來自于常見的漫反射場景,因此模型無法從單目圖像中正确預測與透明物體的距離。

張峻瑞與人工智能與自動化學院的研究生黎家骐、黃亞川等在曹治國教授指導下,針對非朗伯表面的深度估計挑戰提出了三點改進。首先,考慮到相比于朗伯體,光照對于非朗伯體的成像具有更顯著的影響,論文使用随機色調映射等數據增強手段提升深度預測模型對于不同光照條件下非朗伯體的預測魯棒性;其次,作者發現利用區域語義引導的損失函數可以使深度預測模型直接學習到非朗伯表面的特殊幾何特征,使整體框架不再像此前工作一樣嚴重依賴于模型輸入側基于超參的圖像編輯,從而達到更好的性能;最後,在多重曝光圖像可用的情況下,論文還提出了一個新穎的基于變分自編碼器的圖像融合模塊,利用多張不同曝光條件的圖像合成出一張對非朗伯體深度估計最為有利的輸入圖像。實驗結果表明,論文提出的方法在多種場景中表現卓越,其深度估計結果比基準模型ZoeDepth和其他參賽團隊的模型更接近于真實的深度圖(GT)。無論在光照變化或其他複雜環境下,其預測結果均顯現出更高的準确性和穩定性,尤其在基于非朗伯表面的定量指标上全面超越參賽其他團隊,最終摘得比賽桂冠。

ECCV是由歐洲計算機視覺協會(European Computer Vision Association, ECVA)主辦的雙年度國際學術會議,與CVPR和ICCV并稱為國際計算機視覺領域的“三大頂會”。除了計算機視覺領域的每年最新研究成果在大會發表以外,會議還針對當前計算機視覺領域的一些挑戰難題和熱點問題組織全球挑戰賽,吸引了全球衆多知名高校和研究人員參與。

張峻瑞自加入曹治國教授團隊以來,在确定了以單目深度預測為主要研究方向後,與團隊的研究生一道,刻苦鑽研,成果突出,這次是其在奪得CVPR2024組織的單目深度預測競賽“NTIRE HR Depth from Images of Specular and Transparent Surfaces Challenge”賽道冠軍後的又一次奪冠。